En hårt pressad chef på Apple* nämner i förbifarten (enligt vittnen, det saknas tydligen inspelningar) att Google Sök minskat på iPhones för första gången någonsin. Googles aktie dyker med 7,5%.

I en annan del av världen skriver jag: “I want statistics on how much time people spend in the most popular apps on a phone” i ChatGPT:s textfält och går iväg och gör en kopp te. Det tar nämligen lång tid innan man får ett svar - 1 minut och 19 sekunder den här gången, vilket, för någon som minns när Google skröt om att de levererade resultat på 0,03572 sekunder, är en evighet.

Men istället för att få Googles allt bedrövligare resultatsida, med föreslagna frågor, shoppingkaruseller och SEO-spam, får jag en sammanfattning jag snabbt kan skumma igenom, med en tabell och länkar till sidorna som siffrorna är hämtade från. Visst, en hel del SEO-spam där med, och vissa hallucinationer, men jämfört med Google-SERP:en är det väldigt mycket trevligare.

Den som väntar på något gott

Det här är rasande intressant. Som bekant är det väldigt viktigt att en webbplats eller app laddar snabbt, och framför allt att den svarar snabbt på knapptryck och liknande. Testa själv med den här seghets-simulatorn jag lät ChatGPT bygga åt mig**.

Redan vid 0.4 sekunders fördröjning känns det som att något gått fel.

Sen kan man ju såklart se till att visa användaren att något håller på att hända i bakgrunden, med hjälp av animationer och text. Testa själv i det här exemplet, där du kan slå på och av en indikation på att systemet jobbar.

Nu var det inte uråldrig UX-kunskap kring laddtider jag ville dela med mig av i den här posten, utan vad man kan lära sig av min (vår?) förvånansvärt höga tolerans för Copilots, ChatGPT:s och Geminis svarstider. Jag kan se tre saker som bidrar till att jag hellre låter en chattbott tugga på i en halv oändlighet, än sitter med Googles resultat på bråkdelen av en sekund.

Animationer och förklaringar

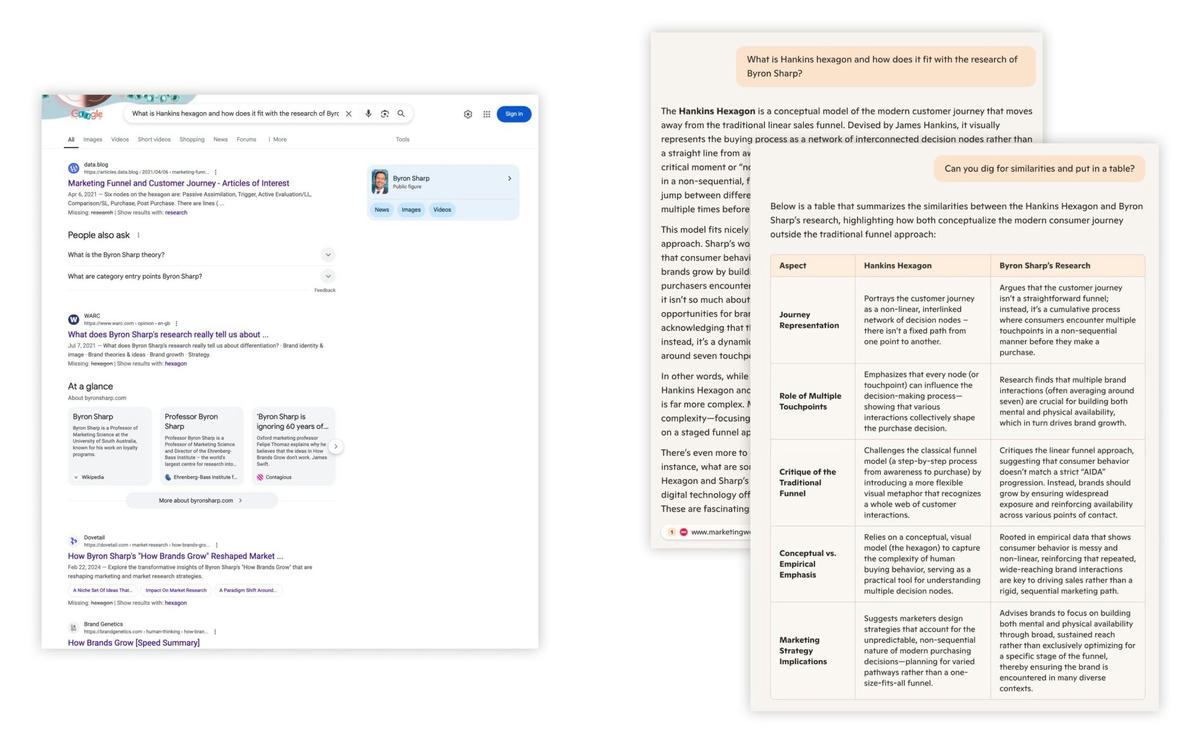

Alla chattbottar jag använt för sök använder sig av det gamla knepet med animationer och texter för att göra väntan lite uthärdligare. Flera av dem skriver ut vad de sysslar med för tillfället. Den som vill ha ett bra exempel kan gå till Googles Gemini och kryssa i “Deep Research”. (Det här med alla olika val och inställningar får bli en annan bloggpost). Be sedan om lite research på något lite mer avancerat, till exempel: “What is Hankins hexagon and how does it fit with the research of Byron Sharp?”

Google har saboterat sin egen produkt

Förutom det här med att botarna hela tiden berättar vad de gör, eller åtminstone visar en liten animation, så tror jag inte man kan underskatta hur mycket skada Prabhakar Raghavan gjorde under sin tid som sökchef på Google. I korthet prioriterade han annonsvisningar över bra sökresultat. Fler sökningar ger ju fler möjligheter att visa annonser, vilket resulterat i dagens SERP. Vill du läsa en detaljerad genomgång finns det en prisbelönt sådan här: The Man Who Killed Google Search.

Hur som helst så har Googles försämrade sökresultat öppnat för konkurrenter. Det gör inget att AI-söken gör fel här och där, för det är lika illa på Google. Ta exemplen i bilden här intill: på ena sidan Googles SERP, och på den andra Copilots svar, båda på frågan: What is Hankins hexagon and how does it fit with the research of Byron Sharp?

Inget av svaren som syns i Googles screenshot svarar på frågan. Visst får man ha lite överseende med det eftersom det är en extremt nischad fråga, men Copilot lyckas trots allt hitta några likheter och ge mig källor där jag själv kan läsa vidare. Med Copilot och de andra AI-söken kan jag dessutom ställa följdfrågor, till exempel: “Lägg likheterna i en tabell”.

Allt detta borde Google ha byggt för flera år sedan. Det var de som uppfann transformermodellen som ligger till grund för dagens LLM-drivna chattbottar. Istället gav de oss allt färre organiska träffar och massa köpt klödd.

Man kan sympatisera med jobbet LLM:en gör

2024 stod Google på scen under sin utvecklarkonferens Google I/O sa att vi skulle låta Google googla åt oss. Ett öppet medgivande att sökresultatssidan inte är någon vidare upplevelse.

Vi vet alla hur tråkigt det kan vara att söka efter något på internet eftersom vi gör det flera gånger om dagen. Vi vet hur svårt det kan vara att hitta rätt information. Så vi förlåter chattbottarnas misstag. Vi har gjort samma missar själva tusen gånger om och är tacksamma för all tid vi sparar, trots långsammare resultat.

Vad betyder allt detta?

Den absolut viktigaste lärdomen att ta med sig från detta är att även de mest uppenbara sanningar kan falla. Självklart är det viktigt att webbsidor laddar och reagerar snabbt, men om man fokuserar på användarens verkliga behov kan man hitta nya sätt att få ett övertag. Det är till exempel komiskt att se hur Google förser oss med autogenererade frågor, när det man egentligen ville ha var ett svar.

“Jobs to be Done”-ramverket handlar helt och hållet om detta, och det finns gott om exempel där nya värden kan ge ett företag övertag:

Ett tag tävlade mobiltelefontillverkare om att göra den tunnaste och lättaste telefonen, men sedan insåg kunder att några timmars extra batteritid var viktigare än en 2 mm tunnare telefon.

Robotdammsugare är inte riktigt lika bra som manuella, å andra sidan dammsuger de av sig själva, och kan göra det varje dag medan man är på jobbet.

GoPro har sämre videokvalitet än en iPhone, å andra sidan kan man spänna fast den på hjälmen när man kajakar i en kloak

Den föga överraskande insikten blir:

Det är en bra idé att hjälpa sina kunder med det problem de har.

Frågan är: varför är det är så många som inte gör det?

*Apple har ställt till det för sig genom att bland annat ljuga i rätten: www.nytimes.com/2025/05/09/technology/apple-app-store-antitrust.html

** Vill du själv komma igång och vibe-koda? Följ den här bloggposten: Koda en app med hjälp av AI