AI-hårdvara, en kort historik

Sam Altman, känd från OpenAI, och Jony Ive, designern bakom iPhone, iMac, Apple Watch och så vidare, har annonserat att de ska ta fram en revolutionerande ny AI-hårdvara. I ett försök att gissa vad det kan bli, kommer här en historisk genomgång av hårdvara som tagits fram speciellt för AI.

Den första eran: I början var ordet

Lite otippat var det e-handelsföretaget Amazon som först släppte en enhet med fokus på att underlätta för människor att interagera med en AI. De köpte upp ett polskt företag och lanserade deras produkt under namnet Alexa i slutet av 2014. Det blev en braksuccé.

Idén byggde på en kombination av högtalare och mikrofon som alltid var inkopplad och lyssnade efter en kodfras, eller som i Alexas fall, ett ord. Användaren kunde sedan be om olika saker, till exempel vädret eller att sätta ett larm. Det blev aldrig riktigt bra. Google och Apple följde efter med sina egna “smarta” högtalare, men inte heller de var särskilt bra.

Jag har en Google Home i köket som jag använder som äggklocka och radio. Jag hade definitivt ersatt den om den gick sönder. Det är smidigt att säga “Hej Google, jag vill lyssna på nyheter” och få det senaste avsnittet av Ekot uppspelat, samt att kunna sätta timers utan att behöva tvätta händerna när jag bakar. Men känslan av att tala med något hyfsat smart som kunde allt gick över väldigt snabbt.

Den andra eran: Se på mig

Något annat som gick snabbt var insikten att det behövs en touchskärm för väldigt mycket av det man vill göra. Idag erbjuder både Google och Amazon versioner av sina “smarta” högtalare med inbyggda skärmar, men det var inte tillräckligt för att blåsa nytt liv i segmentet för assistenthårdvara. Hårdvaran är nog helt okej, men mjukvaran var helt enkelt för kass. Röstassistenter blev något av ett skämt. Alla som använt Siri, Alexa eller Google Assistant vet att de ofta missförstår vad man säger och ännu oftare gör helt fel.

Mellanakt 1

Det finns två stora problem med röstassistenter. Det ena är att det som användare är svårt att förstå vad man kan göra med dem. Det man på UX-språk kallar affordances, verbs och mental mappings försvåras av att systemet man interagerar med är osynligt.

Röstassistenterna lyssnar hela tiden efter att användaren skall säga ett triggerord ur en av flera listor. Till exempel: jag LETAR efter en FLYGBILJETT, jag vill KÖPA en BILJETT, eller jag vill FLYGA. Säger man inte ett sådant ord händer ingenting, och det finns inget rimligt sätt att lista ut vilka ord man som användare har “tillgång” till.

Detta leder vidare till det andra stora problemet: att assistenterna var för korkade. Som användare trodde man att man kunde prata som vanligt och bli förstådd, när det i själva verket handlade om att snubbla över rätt kommando. Systemet var för dumt för att förstå naturligt tal, helt enkelt.

Men så dök Transformer-modellen upp (den som gör att Gemini, Copilot, Claude och så vidare är så bra på att tolka vardagligt tal) och nästa era kunde börja.

Den tredje eran: Alltid vid din sida

I början av 2024 släppte det nya företaget Rabbit sin nya AI-hårdvara vid namn R1. Det är en väldigt gullig rödorange korsning mellan en mobiltelefon och en walkie-talkie. Tanken är att man ska trycka in en knapp på sidan av enheten och sedan ha ett samtal med en AI. Det finns även en kamera, en pekskärm och en högtalare på enheten. R1 såldes in med löftet om att Rabbits AI skulle kunna utföra allt som en människa kan göra på internet.

Det visade sig vara en lögn, Rabbit R1 kunde i stort sett inte göra någonting, och efter ett tag dök det upp minst sagt osköna berättelser om Rabbits grundare och hans förflutna som cryptoscammer.. R1 finns faktiskt kvar, trots alla negativa recensioner, och en del hävdar att den idag är värd sina 2 000 kronor.

Några andra som inte finns kvar längre är Humane, som släppte produkten AI Pin. Tanken var återigen en pryl man alltid skulle ha med sig, som skulle göra det enklare att interagera med sin LLM-drivna AI-assistent. Förutom kamera och mikrofon hade den dessutom en laserprojektor som kunde visa upp ett avskalat UI i handen på användaren.

Recensionerna var ännu tuffare än de som R1 fick utstå. Det slutade med att HP köpte upp spillrorna av företaget och drog ur kontakten på Humanes servrar den sista februari 2025.

Gemensamt för båda produkterna var att man kunde ta dem med sig ut i världen, och att de skulle befria oss från våra telefoners tyranni. Just det där med att befria oss från mobilens tyranni är lite komiskt eftersom en återkommande kritik var att allt prylarna gjorde kunde göras bättre på en mobiltelefon. Att de egentligen bara borde varit appar, och att de som appar hade varit sämre än de välkända AI-chatbotarna. Men som sagt: varken Rabbit R1 eller AI Pin blev några succéer.

Innan någon av dem hann lanseras, och misslyckas, passade andra framgångssugna entreprenörer på att lansera sina egna projekt. Roligast var (är) nog företaget Friend, som sålde halsband med mikrofon och bluetooth. Och visst är det något lockande med en liten, diskret pryl som ska tillgodose våra behov utan att vi behöver mecka med massa grafiska gränssnitt. Synd bara att ingen lyckas få till det.

Den fjärde eran: Jag kan se

Här är vi nu, och en rolig grej med den här eran är att den uppstod lite som en bieffekt. Det började med att Snapchat skapade sina skojiga Spectacles, eller började det kanske redan när Google släppte Google Glass? Hur som helst var det som verkligen satte fart på den fjärde eran Metas svar på Snapchats Spectacles: Meta Ray-Bans.

Meta byggde in kamera, högtalare och mikrofon i ett par Ray-Bans, vilket till en början mest handlade om att låta folk dela videoklipp från ett förstapersonsperspektiv. Men sedan la de till en översättningsfunktion och lite röstkommandon, inklusive möjligheten att fråga Metas AI vad man tittar på, och vips så hade de en ganska lyckad AI-produkt.

Formatet med en massa sensorer i ansiktet känns igen från floppen Google Glass, vilket inte är så konstigt. Om man nu vill ha hjälp av en chatbot så är det onekligen bra att den får tillgång till vad man ser och hör. Ett par glasögon löser detta, samtidigt som man har händerna fria till att dra ut sina nudlar för hand, skapa ett Totoro-diorama av lera eller fixa kontakten på cykelns navgenerator.

Fast vänta lite nu… allt det där kräver ju en skärm. Något som Metas Ray-Bans helt saknar.

Exakt! Det är vad Metas Project Orion ville lösa. Tänk dig ett par extremt tjockbågade glasögon som försöker se ut som ett par Meta AI-glasögon, bara det att de har skärmar i stil med vad Microsoft hade i sin HoloLens. Det innebär att bilder kan blandas med verkligheten, utan att man ser ut som en knäppgök (eller okej, nästan i varje fall).

Mellanakt 2

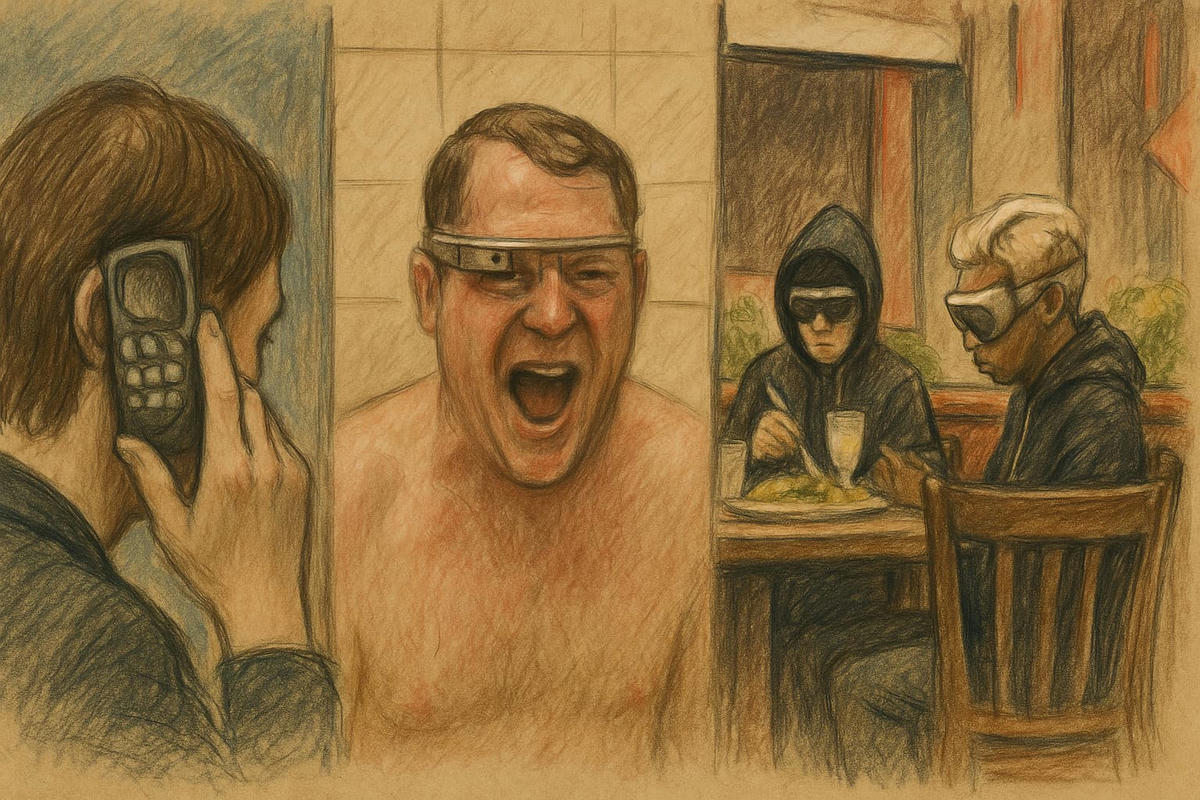

Här får jag göra en liten avstickare med en kort historik över teknik som får folk att se lite knäppa ut™.

Vi börjar med Nokias gamingmobil N-Gage, eller tacotelefonen, som den kom att kallas. Tanken var god: om någon ringde medan man satt och gejmade skulle telefonen smidigt glida in i ett taco-grepp. Folk skrattade, och nästa version av N-Gage fick man hålla på det traditionella sättet.

Nästa stopp blir Robert Scobles legendariska duschbild med ett par Google Glass på. En del säger till och med att just den bilden var orsaken till att Glass aldrig tog fart, att Scoble gjorde att glasögonen för evigt kom att förknippas med knäppgökar.

Vilket tar oss till förra årets stora hårdvarulansering: Apple Vision Pro. Trots att Apple gjorde sitt yttersta för att få den att se coolare ut än andra VR-hjälmar, har den en tung aura av sorglig knäppgök över sig. Inte konstigt att den enda gången Tim Cook synts med den på var under ett strikt kontrollerat photoshoot med Vanity Fair. Inte ens det hjälpte, han ser precis lika hopplöst knäpp ut som stackaren som fick filma Mark Zuckerbergs “spontana” försvarstal till Meta Quest 3.

Tillbaka till den fjärde eran, den med kameror i ansiktet.

Även om Mark Zuckerberg inte klarar av att få Metas Orion-brillor att se coola ut, så ser han inte knäppare ut än vanligt med dem på. En minst sagt heroisk bedrift, värdig den legendariske industridesignern Dieter Rams.

Just när man trodde att läget hade stabiliserats, kommer Google tillbaka med ett par glasögon som känns som Google Glass på steroider. De har tagit fram Android XR, som ska vara ett operativsystem för allt från VR till AR. Vem som helst kan licensiera mjukvaran och bygga sina egna AI-glasögon. Demon de kör är imponerande. Glasögon känns onekligen som den bästa formfaktorn för AI-hårdvara. Eller?

Nästa era: en gåta insvept i ett mysterium

På tal om Dieter Rams har hans största fan, Jony Ive, och OpenAIs Sam Altman något nytt på gång inom AI-hårdvaruvärlden. De har i skrivande stund inte visat något konkret, och antagligen får vi inte se något förrän 2026. Det lilla vi vet är att det:

- Är en produkt som är “fullt medveten om sin ägares omgivning och liv”

- Är en pryl som ska få plats i en ficka

- Ska bli den tredje prylen man lägger på sitt skrivbord efter en laptop och mobil

- Inte är en mobil

- Förmodligen inte är en så kallad wearable

- Inte är ett par glasögon 😮

Okej, så vad är det då? Det enda som är kvar efter alla dessa ledtrådar är en liten låda med mikrofon, kanske en högtalare och varför inte en pekskärm… Låter lite som Rabbit R1.

Så korkade kan de väl inte vara? Eller kanske…? Vem vet. Vi lever i den bästa av alla tänkbara världar.